详细介绍:

Kaggle

全球最大的机器学习和数据科学社区

Kaggle是由Google收购的全球领先的数据科学竞赛平台,为数据科学家、机器学习工程师和AI研究者提供了一个学习、竞赛和协作的综合性平台。本攻略将带您深入了解Kaggle的各项功能,从零基础到高级应用,助您在数据科学之路上取得成功。

平台概述

Kaggle成立于2010年,被Google收购后成为全球最具影响力的数据科学社区

1000万+

注册用户

50,000+

竞赛项目

200,000+

公开数据集

8,000,000+

代码Notebook

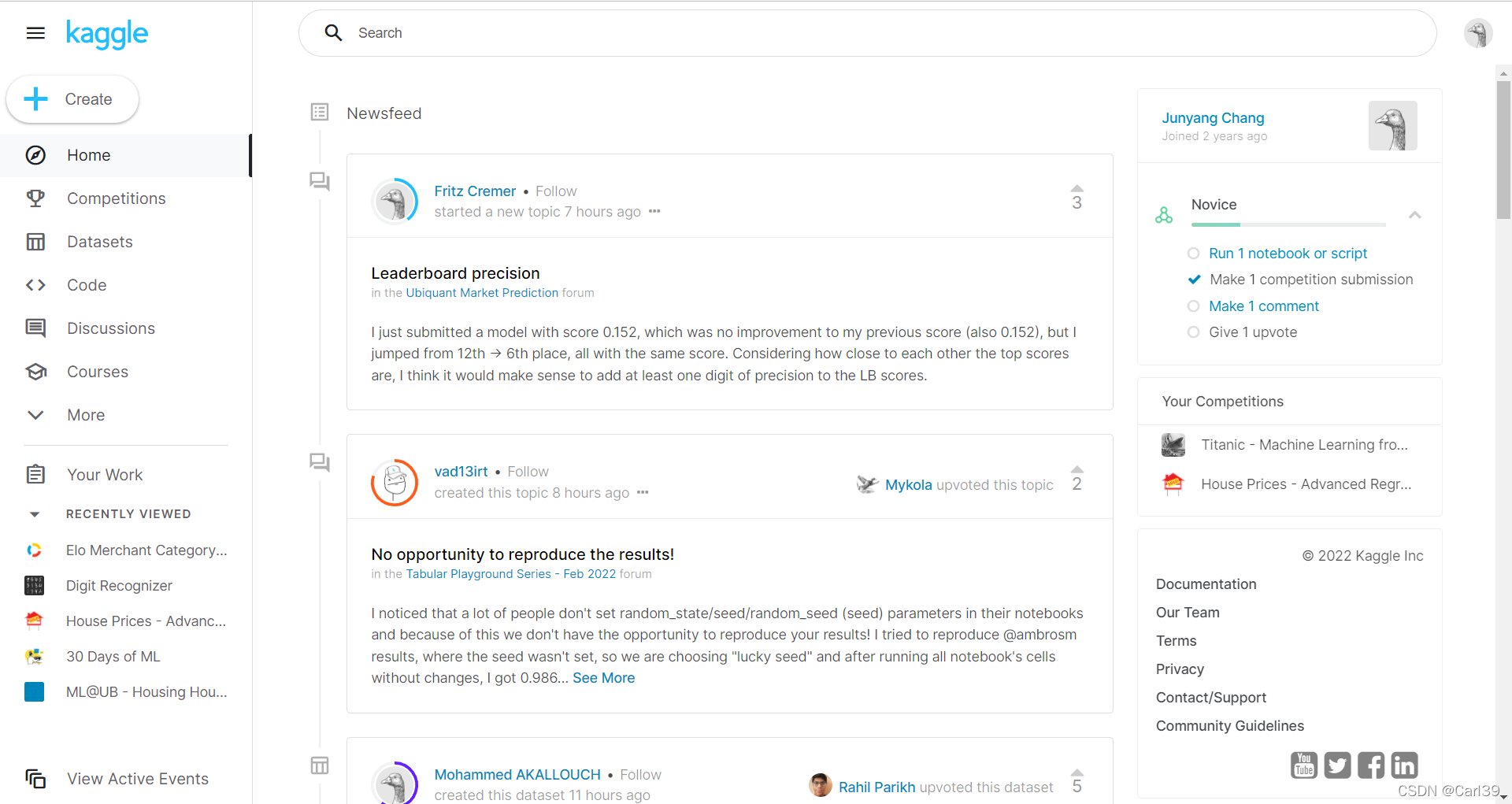

Kaggle平台界面预览

Kaggle平台主界面展示

核心功能模块

Kaggle提供了完整的数据科学生态系统,涵盖学习、实践、竞赛和协作的各个方面

竞赛平台

参与全球顶级数据科学竞赛,挑战真实的业务问题,赢取丰厚奖金和声誉

- • 机器学习竞赛

- • 深度学习挑战

- • 计算机视觉项目

- • NLP自然语言处理

数据集市场

访问数十万个高质量数据集,涵盖各个行业和研究领域

- • 开源数据集

- • 企业级数据

- • 政府公开数据

- • 学术研究数据

Kaggle Notebooks

云端Jupyter环境,免费GPU/TPU计算资源,协作开发

- • 免费GPU加速

- • TPU支持

- • 版本控制

- • 团队协作

Learn课程

免费的微课程体系,从入门到高级,系统学习数据科学

- • Python编程

- • 机器学习基础

- • 深度学习

- • 数据可视化

Discussion论坛

活跃的社区讨论,分享经验、解决问题、交流见解

- • 技术讨论

- • 解决方案分享

- • 新手答疑

- • 行业动态

进阶系统

完善的等级和认证体系,展示您的数据科学技能和成就

- • Novice 新手

- • Contributor 贡献者

- • Expert 专家

- • Master/Grandmaster 大师

入门指南

从零开始,轻松上手Kaggle平台的各项功能

注册账户

访问 kaggle.com 创建免费账户,可以使用Google、Facebook或邮箱注册

注册建议:

- • 使用真实姓名,便于建立专业声誉

- • 完善个人资料,包括技能和兴趣

- • 设置合适的头像,提升个人品牌

完成Learn课程

从Python基础开始,逐步学习机器学习核心概念

必修课程

- • Python

- • Intro to Machine Learning

- • Pandas

- • Data Visualization

进阶课程

- • Intermediate Machine Learning

- • Deep Learning

- • Computer Vision

- • Natural Language Processing

探索数据集

从简单的数据集开始练习,熟悉数据分析流程

推荐入门数据集:

- • Titanic: 经典的生存预测问题,最适合新手

- • House Prices: 房价预测,回归问题入门

- • Iris Dataset: 鸢尾花分类,经典机器学习案例

- • MNIST: 手写数字识别,计算机视觉入门

创建第一个Notebook

使用Kaggle的云端环境进行数据分析和建模

# 导入基础库

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

# 读取数据

df = pd.read_csv('/kaggle/input/dataset-name/data.csv')

df.head() 参加第一个竞赛

选择"Getting Started"类别的竞赛开始实战

新手友好的竞赛:

- • Titanic - Machine Learning from Disaster

- • House Prices - Advanced Regression Techniques

- • Digit Recognizer

- • Natural Language Processing with Disaster Tweets

竞赛参与指南

掌握Kaggle竞赛的制胜策略和实用技巧

竞赛类型

Featured Competitions

高奖金的主要竞赛,通常由大公司赞助,奖金可达数十万美元

Research Competitions

学术研究导向的竞赛,专注于推进科学发现和创新方法

Getting Started

新手友好的入门竞赛,提供学习资源和社区支持

Playground

练习竞赛,没有时间限制,适合学习和实验

竞赛策略

深入理解问题

- • 仔细阅读竞赛描述和评估指标

- • 分析数据特征和分布

- • 研究领域背景知识

探索性数据分析

- • 数据质量检查和清理

- • 特征工程和变换

- • 可视化数据分布和关系

模型构建和优化

- • 尝试多种算法和方法

- • 交叉验证和参数调优

- • 模型集成和融合

社区参与

- • 阅读讨论区的见解分享

- • 学习其他参赛者的方法

- • 分享自己的发现和经验

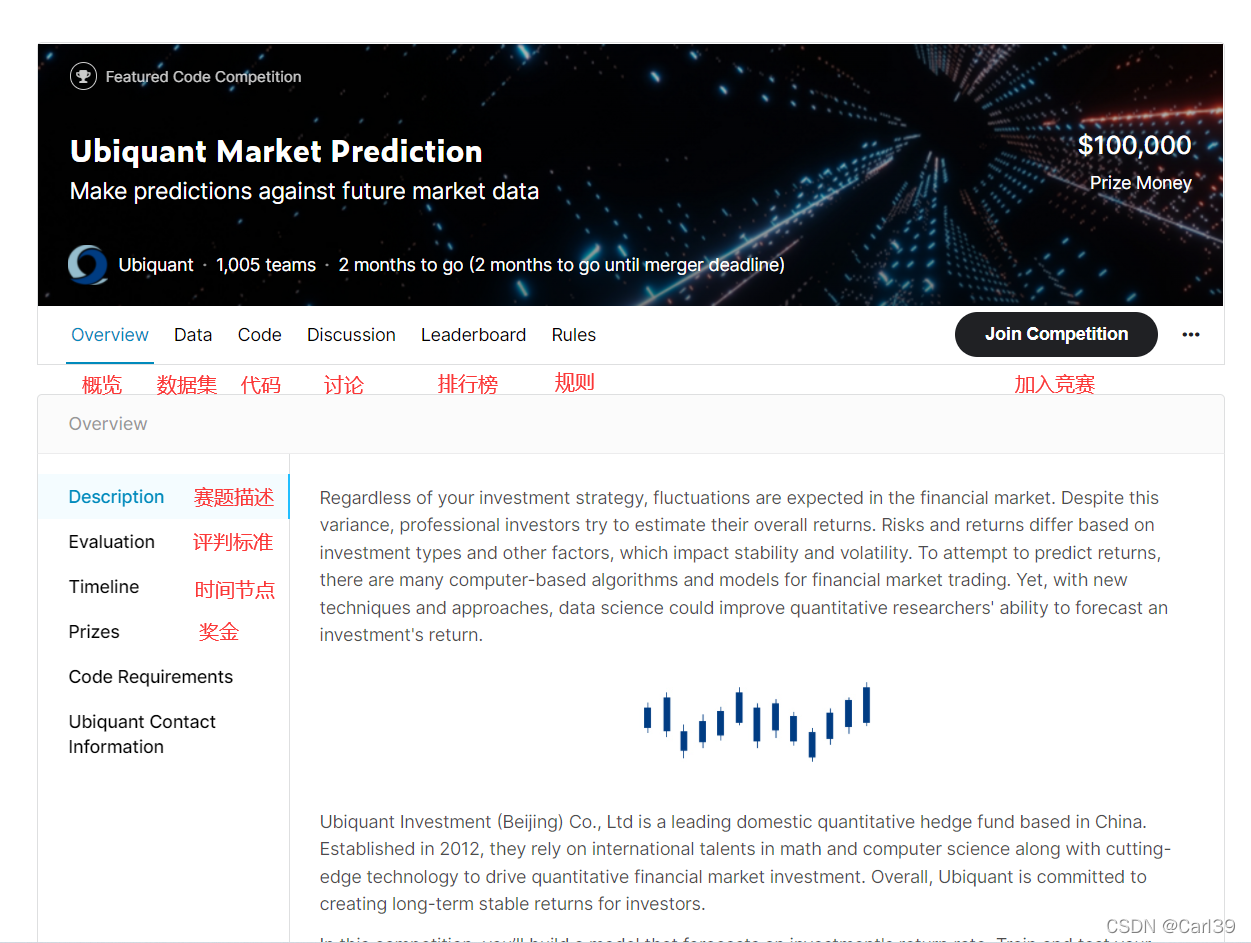

竞赛界面示例

Kaggle竞赛页面界面展示

数据集与Notebook开发

充分利用Kaggle的数据资源和云端开发环境

数据集使用

热门数据集类别

商业分析

医疗健康

计算机视觉

自然语言处理

社会科学

金融数据

数据集搜索技巧

- • 使用标签和关键词精确搜索

- • 按照更新时间、下载量排序

- • 查看数据集的用途和许可证

- • 阅读用户评论和使用案例

- • 关注数据质量和完整性

Notebook开发

免费计算资源

GPU加速

每周30小时免费

TPU支持

每周30小时免费

内存容量

最高13GB RAM

存储空间

20GB临时存储

Notebook最佳实践

- • 清晰的标题和说明文档

- • 结构化的代码组织

- • 充分的注释和解释

- • 可视化结果和发现

- • 版本控制和备份

- • 公开分享优质内容

# Kaggle Notebook 基础模板

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

# 设置绘图样式

plt.style.use('seaborn')

sns.set_palette("husl") 学习资源与进阶路径

从新手到专家的完整学习路径和资源推荐

官方课程

- Python: 编程基础,数据处理核心技能

- Intro to Machine Learning: 机器学习入门概念

- Intermediate Machine Learning: 进阶技术和方法

- Pandas: 数据分析和处理利器

- Data Visualization: 数据可视化技巧

- Deep Learning: 深度学习实战

- Computer Vision: 计算机视觉应用

- Natural Language Processing: 自然语言处理

社区资源

- Discussion Forums: 活跃的技术讨论社区

- Public Notebooks: 优质代码和分析案例

- Solutions & Write-ups: 竞赛解决方案分享

- Kaggle Days: 全球线下活动和会议

- Expert Interviews: 专家访谈和经验分享

- Blog Posts: 深度技术文章和教程

进阶等级系统

Novice

新手级别,完成基础课程和第一次提交

Contributor

贡献者,积极参与社区活动和分享

Expert

专家级别,在特定领域表现优秀

Master

大师级别,多个领域的顶尖表现

高级技巧与最佳实践

掌握这些技巧,让您在Kaggle平台上取得更好的成绩

模型优化策略

模型集成 (Ensemble)

- • Voting: 多个模型投票决定最终结果

- • Stacking: 使用元学习器组合多个基模型

- • Blending: 按权重混合不同模型的预测

- • Bagging: 通过自助采样训练多个模型

特征工程技巧

- • 特征选择: 使用统计方法筛选重要特征

- • 特征构造: 创建交互特征和衍生特征

- • 特征编码: 处理类别变量和文本数据

- • 特征缩放: 标准化和归一化数值特征

交叉验证策略

- • K-Fold CV: 标准的k折交叉验证

- • Stratified CV: 保持类别比例的分层验证

- • Time Series CV: 时间序列数据的验证方法

- • Group CV: 防止数据泄露的分组验证

竞赛心得分享

成功要素

- • 深入理解数据: 花时间做充分的EDA

- • 稳定的验证: 建立可靠的本地验证策略

- • 持续迭代: 小步快跑,频繁提交和测试

- • 学习分享: 积极参与讨论,学习他人经验

常见陷阱

- • 过拟合: 过度优化公开排行榜

- • 数据泄露: 使用未来信息预测过去

- • 验证不当: 本地验证与线上不一致

- • 时间管理: 没有合理分配时间和精力

获奖策略

- • 团队合作: 组建互补技能的团队

- • 多样化模型: 尝试不同类型的算法

- • 领域知识: 学习相关的专业知识

- • 坚持到底: 持续优化到最后一刻

高级代码示例:模型集成

# 模型集成示例

from sklearn.ensemble import VotingClassifier

from sklearn.linear_model import LogisticRegression

from sklearn.ensemble import RandomForestClassifier

from sklearn.svm import SVC

# 定义基础模型

clf1 = LogisticRegression(random_state=42)

clf2 = RandomForestClassifier(random_state=42)

clf3 = SVC(probability=True, random_state=42)

# 创建投票集成器

ensemble = VotingClassifier(

estimators=[('lr', clf1), ('rf', clf2), ('svc', clf3)],

voting='soft'

)

# 训练集成模型

ensemble.fit(X_train, y_train)

predictions = ensemble.predict(X_test) 成功案例与经验分享

从Kaggle社区中学习顶级数据科学家的成功经验

Grandmaster之路

案例:从零基础到Kaggle Grandmaster的3年历程

- • 第1年:完成Learn课程,参与入门竞赛

- • 第2年:专注特定领域,建立稳定方法论

- • 第3年:团队合作,冲击排行榜前列

关键建议:持续学习新技术,积极参与社区讨论,建立个人品牌

职业转型

案例:通过Kaggle成功转入数据科学领域

- • 建立完整的项目作品集

- • 获得行业认可的技能证明

- • 通过竞赛结果展示实力

职业价值:Kaggle成绩是数据科学求职的重要加分项

技术突破

案例:在ImageNet等顶级竞赛中的创新方法

- • 创新的数据增强技术

- • 新颖的模型架构设计

- • 高效的训练策略优化

学术影响:许多Kaggle创新方法后来成为学术标准

数据科学学习统计

开始您的Kaggle之旅

Kaggle不仅仅是一个竞赛平台,更是一个完整的数据科学学习和成长生态系统。通过参与竞赛、使用数据集、开发Notebook和参与社区讨论,您将建立起扎实的数据科学技能基础,并有机会与全球顶尖的数据科学家交流学习。

立即开始

访问Kaggle.com注册账户,完成第一个Learn课程

加入社区

参与讨论,分享您的见解,从社区中学习

持续进步

不断挑战自己,在实践中提升技能水平

有用的资源链接

学习资源

本攻略涵盖了Kaggle平台的主要功能和使用技巧,希望能帮助您在数据科学的道路上取得成功。记住,持续学习和实践是提升技能的关键!

执业医师资格考试培训

执业医师资格考试培训 免费试听

免费试听 执业药师考试培训

执业药师考试培训